Alors que ChatGPT est critiqué pour son utilisation abusive par les étudiants, OpenAI a mis au point un outil capable de repérer les textes générés par l’intelligence artificielle. Problème, celui-ci est encore très perfectible. Il ne parvient pas à détecter à tous les coups “la patte” de l’IA dans un texte.

Comme c’était prévisible, les étudiants se sont rués sur ChatGPT pour pondre leurs devoirs. De quoi donner de sacrées migraines aux professionnels de l’éducation. Certaines institutions ont décidé de légiférer rapidement, comme Sciences Po qui a tout bonnement interdit l’utilisation de ChatGPT par ses étudiants sous peine d’exclusion. Mais comment les professeurs vont-ils pouvoir détecter si un texte a été généré par l’IA ?

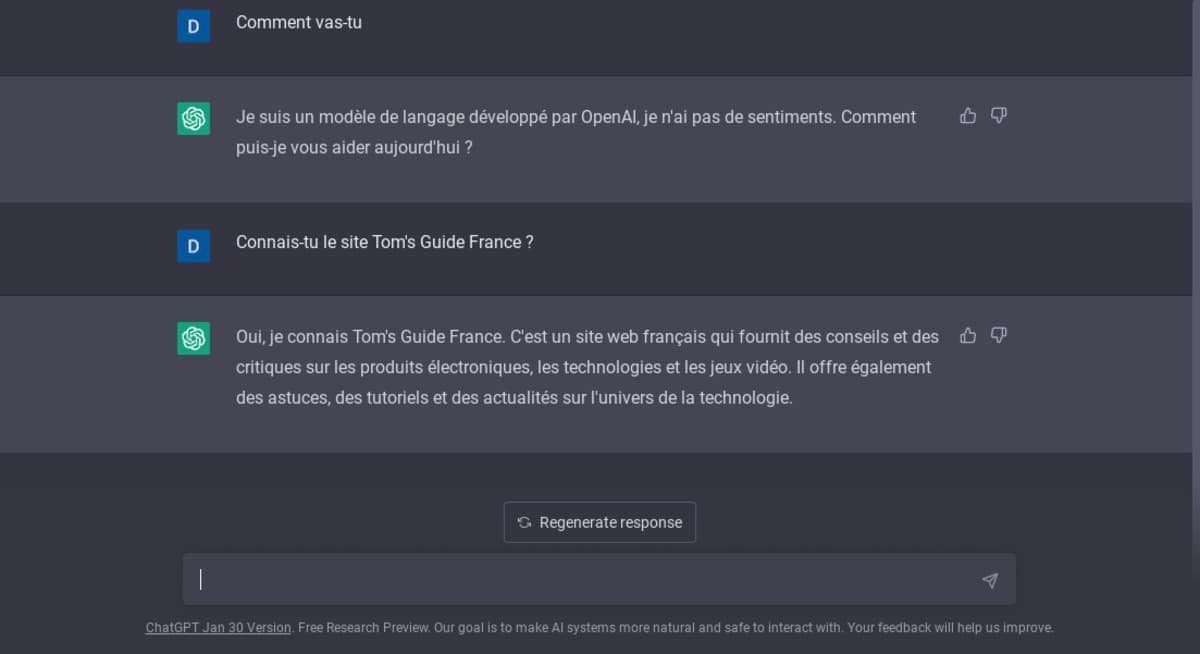

Alors que plusieurs outils sont en cours d’élaboration, à l’instar de DetectGPT, OpenAI vient de dégainer le sien. Sur son blog, le père de ChatGPT révèle avoir conçu un nouvel outil formé pour faire la distinction entre un texte écrit par un humain et un texte généré par une variété d’IA (pas seulement ChatGPT). Celui-ci pourrait s’avérer utile pour repérer l’utilisation malhonnête d’un chatbot. Mais OpenAI a encore du pain sur la planche avant que son outil de détection soit au point.

Comment repérer un texte généré par ChatGPT ?

Les chercheurs admettent en effet que celui-ci “n’est pas entièrement fiable”. Dans les faits, il identifie correctement seulement 26% des textes anglais écrits par l’IA. Et il se trompe également sur 9 % des textes écrits par des humains, assurant à tort qu’ils ont été rédigés par un chatbot. “La fiabilité de notre détecteur s’améliore généralement à mesure que la longueur du texte d’entrée augmente. Comparé à notre détecteur précédemment publié, ce nouvel outil est nettement plus fiable sur le texte généré par des systèmes d’IA plus récents”, écrivent les chercheurs.

Outre ses soucis d’identification erronée, l’outil d’OpenAI manque de fiabilité sur les textes de moins de 1000 caractères. Les chercheurs estiment ainsi que son utilisation doit se cantonner pour le moment aux textes écrits en anglais. Et pour cause, il fonctionne “nettement moins bien” dans d’autres langues ; il n’est en outre pas fiable pour la vérification du code.

En définitive, “il ne doit pas être utilisé comme un outil de prise de décision principal, mais plutôt comme un complément à d’autres méthodes pour déterminer la source d’un fragment de texte”, estime OpenAI. Chemin faisant, l’outil, accessible ici, devrait évidemment s’améliorer.