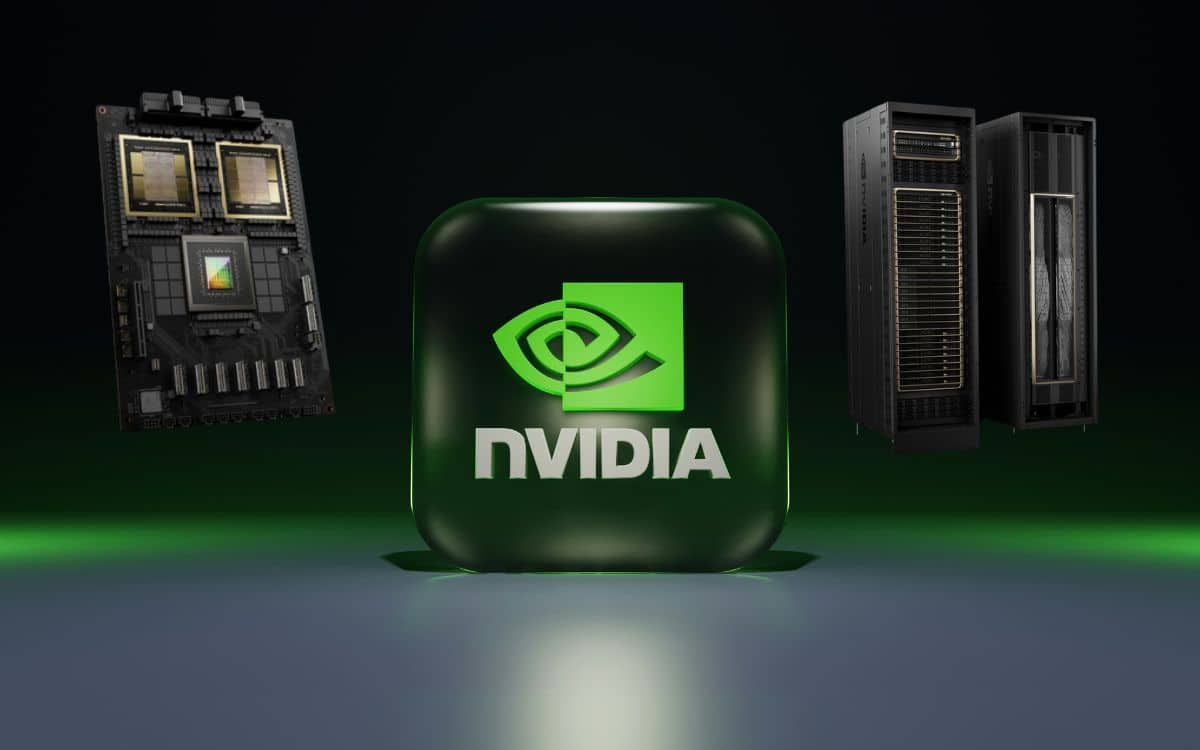

Le PDG de Nvidia présentait hier le nouveau GPU dédié à l’intelligence artificielle (IA) de son entreprise, le B200. S’appuyant sur une nouvelle architecture nommée Blackwell, cette puce démultiplie les performances tout en réduisant la consommation d’énergie.

Hier soir, l’homme qui affirme que l’IA surpassera les humains d’ici 5 ans présentait une nouvelle avancée dans ce domaine. Le PDG de Nvidia, Jensen Huang, révélait devant un parterre de 18 000 personnes la puce Blackwell B200 et la “superpuce” GB200, conçues pour les calculs d’intelligence artificielle. Pour introduire ses nouvelles créations, le cofondateur de Nvidia déclarait : « Nous avons besoin de plus gros GPU ». La couleur (verte) est annoncée.

Que propose la puce Blackwell B200 de Nvidia ?

Actuellement, le GPU le plus répandu pour les calculs d’IA est le Nvidia H100, une puce qui équipe notamment le supercalculateur de Tesla. Ce composant s’arrache à plus de 40 000 dollars l’unité entre les entreprises du secteur comme OpenAI. Des cartes plus vieilles, comme la A100 pourtant lancée en 2020, se vendent encore à 20 000 dollars. Ces puces ont fait de Nvidia la troisième capitalisation boursière au monde, juste derrière Apple.

Les puces Blackwell vont plus loin que ces GPU au succès retentissant. Le nouveau GPU B200 offre jusqu’à 20 pétaflops de puissance FP4 grâce à 208 milliards de transistors. La superpuce GB200, elle, combine deux de ces GPU avec un processeur Grace, pour offrir des performances 30 fois supérieures pour les calculs d’inférence, c’est-à-dire ceux destinés à faire tourner les grands modèles de langage comme GPT.

Sur un benchmark GPT-3 LLM avec 175 milliards de paramètres, Nvidia affirme que le GB200 offre des performances sept fois plus élevées que celle d’un H100. Nvidia affirme qu’il offre également une vitesse d’apprentissage quatre fois plus élevée, c’est-à-dire les calculs destinés à former les grands modèles de langage.

À lire > DLSS : c’est quoi cette technologie graphique de Nvidia ?

Le GPU B200 est plus économe en énergie que les autres puces de Nvidia

Mais ce n’est pas qu’en termes de performances que l’avancée est significative. Tout le monde le sait, la consommation électrique de l’IA est énorme. Ces cartes sont justement beaucoup plus efficaces. “Le GB200 réduit le coût et la consommation d’énergie jusqu’à 25 fois moins” par rapport à un H100, affirme Nvidia.

À titre d’exemple, la formation d’un modèle de 1,8 trillion de paramètres aurait auparavant nécessité 8 000 GPU Hopper et 15 mégawatts d’énergie, selon Nvidia. Aujourd’hui, Jensen Huang explique que 2 000 GPU Blackwell peuvent le faire en consommant seulement quatre mégawatts.

Une belle avancée technologique, mais pas de l’opinion des investisseurs ! L’annonce de l’architecture Blackwell et du GPU B200 a fait baisser l’action de Nvidia de 1,77 %, au lieu de poursuivre l’augmentation insolente de douze derniers mois. Nvidia ne dépassera pas Apple. Pour l’instant du moins.

Source : Bloomberg

- Le PDG de Nvidia, Jensen Huang, a présenté hier soir son nouveau GPU dédié aux calculs d’IA.

- Le GPU se combine dans une superpuce, le GB200, qui offre des performances démultipliées.

- C’est aussi en termes de consommation électrique que la puce offre une énorme avancée.