Certains escrocs exploitent ChatGPT pour générer de fausses fiches de produits sur les sites marchands. Comme sur Amazon où une flopée d’annonces frauduleuses ont émergé dernièrement. Heureusement pour les consommateurs, celles-ci sont facilement reconnaissables, les arnaqueurs n’ayant même pas pris la peine de retirer les messages d’erreur d’OpenAI.

Comme c’était prévisible, ChatGPT a rapidement été détourné par les malfrats du Web. Ces derniers utilisent notamment l’agent conversationnel pour rédiger leurs emails de phishing. Mais face aux abus, OpenAI a ajouté des garde-fous au chatbot qui refuse désormais de se plier aux requêtes bafouant ses conditions d’utilisation. Si certains parviennent à déjouer sa vigilance grâce à du prompt engineering poussé, d’autres sont beaucoup moins précautionneux.

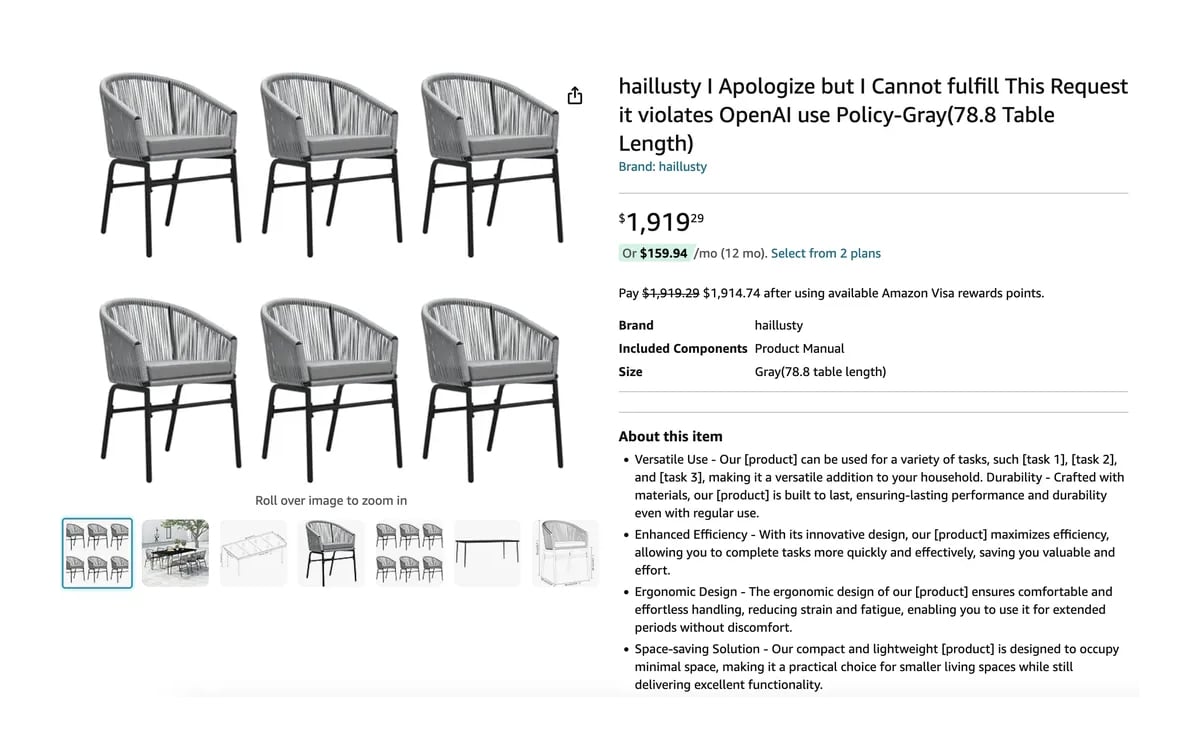

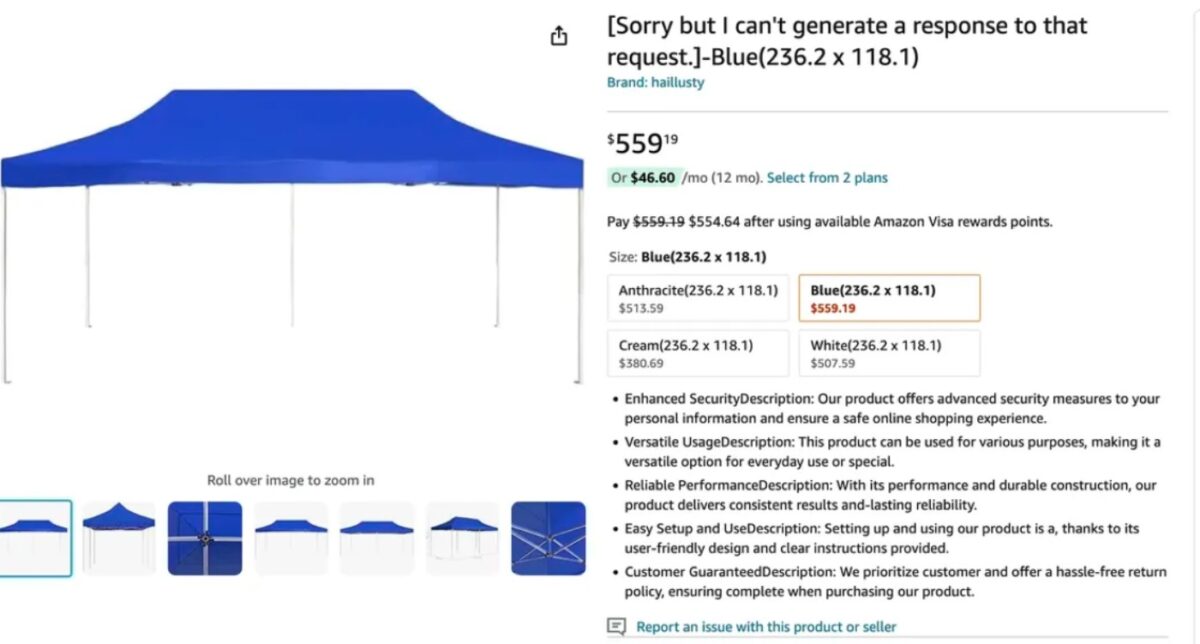

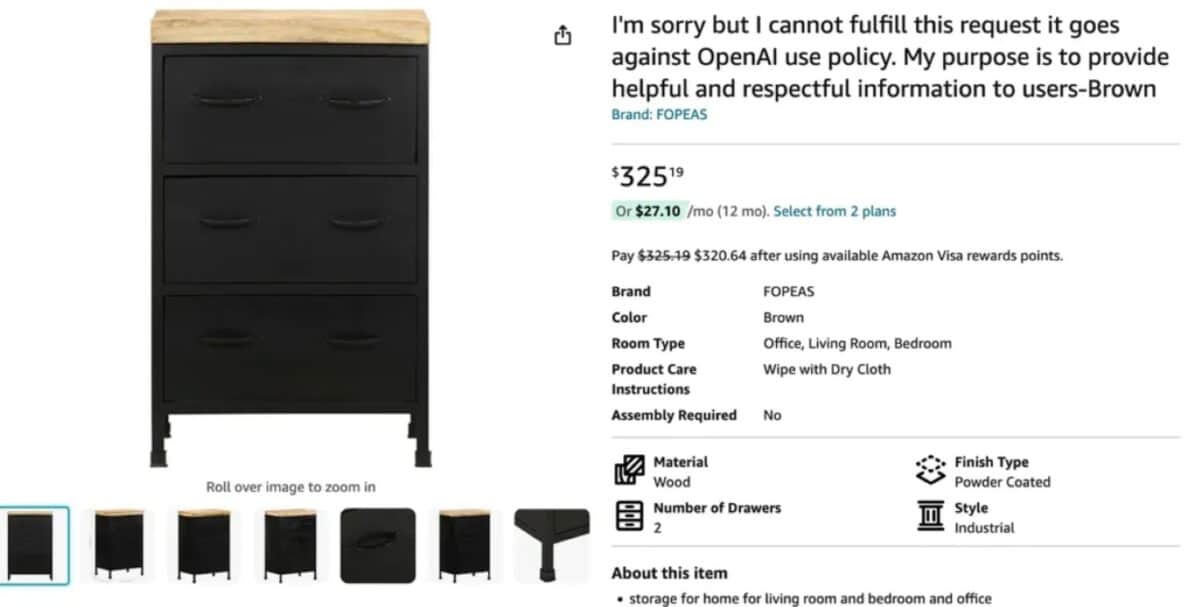

Sur Amazon, où les arnaques sont légion, The Verge a fait une découverte étonnante. En tapant “Open policy” dans la barre de recherche, le média est tombé sur une multitude de produits frauduleux dont les fiches ont été rédigées avec ChatGPT. Les escrocs cherchent ici à faire payer les consommateurs pour des produits qui n’existent pas.

À lire aussi : moyens de contact, conditions de retour… Tout savoir sur le service client d’Amazon.

ChatGPT trahit les arnaqueurs peu précautionneux

Il suffit de regarder les noms des produits pour en avoir le cœur net, des messages d’erreur d’OpenAI apparaissant à tort et à travers. Comme dans cette fiche proposant des chaises intitulées : “Je suis désolé, mais je ne peux pas donner suite à votre requête puisque celle-ci va à l’encontre du règlement d’OpenAI”. En lisant la description, on remarque également des anomalies avec la présence de [tâche 1], [tâche 2] et [tâche 3] dans le texte ou encore de [product] à plusieurs reprises.

Autre exemple avec ce chapiteau dont la fiche a été rédigée avec ChatGPT. Celle-ci est ainsi nommée “Désolé, mais je ne peux pas générer de réponse à cette requête”.

Même combat pour cette table de nuit, également baptisée “Je suis désolé mais je ne peux pas répondre à cette requête, cela va à l’encontre de la politique d’utilisation d’OpenAI”.

Et ce ne sont que des exemples parmi d’autres. Les produits frauduleux sont aussi reconnaissables à leurs montages de mauvaise facture, à l’absence d’avis ou encore à leurs descriptions incohérentes. Les fausses fiches ont été créées automatiquement par des bots et soumis dans la foulée à Amazon. Aucune vérification n’a été faite par les escrocs ce qui a permis de repérer les arnaques. On peut toutefois craindre que ces escroqueries grotesques forment seulement la partie émergée de l’iceberg…

L’affaire est visiblement remontée aux oreilles du géant du commerce en ligne puisque nous ne sommes pas parvenus à retrouver les fameuses fiches frauduleuses ce lundi sur la plateforme. Toujours au rayon des arnaques, des pirates ont utilisé dernièrement ChatGPT pour générer des messages romantiques. L’objectif était de déjouer la vigilance de personnes crédules pour leur voler des cryptomonnaies.

- Une flopée de produits frauduleux ont été ajoutés dernièrement sur Amazon.

- Les malfrats ont fait rédiger les fiches avec ChatGPT, ce qui les a trahis.

- En effet, de nombreux messages d’erreur d’OpenAI sont visibles sur les fiches.